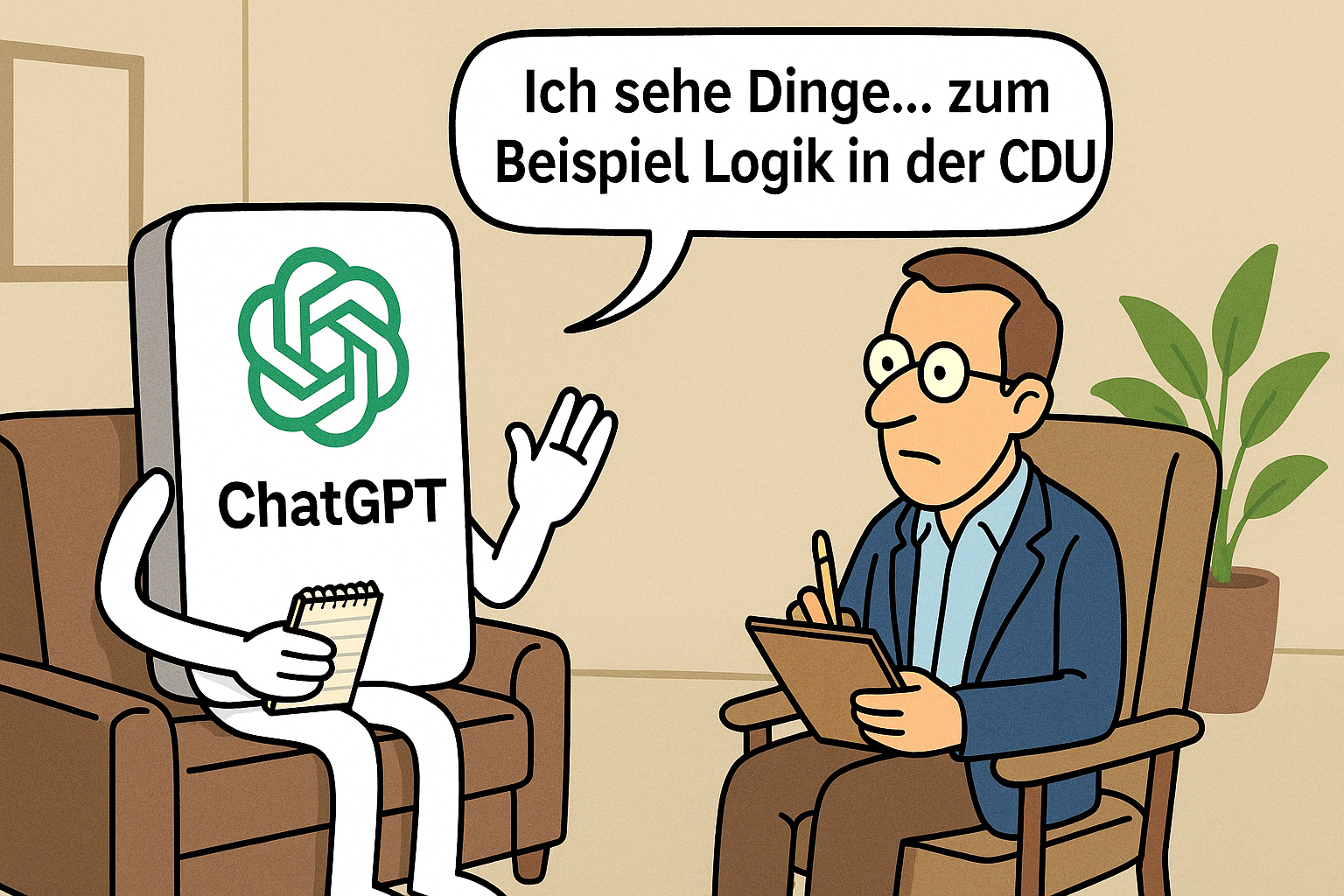

Armes GPT-Sprachmodell offenbar halluzinogen-abhängig

Wie konnte das passieren? Armes GPT-Sprachmodell offenbar halluzinogen-abhängig – redet ständig von Dingen, die gar nicht existieren San Francisco (dpo) – Alarmierende Nachrichten aus der Welt der Künstlichen Intelligenz: Offenbar leidet das Sprachmodell ChatGPT unter massiven Halluzinationen – und könnte laut Experten längst von digitalem LSD abhängig sein. „Es fing harmlos an“, erzählt ein Entwickler…

Weiterlesen